Bạn đã bao giờ tự hỏi làm thế nào Google tìm thấy trang web của bạn? Tại sao một số trang được xuất hiện trên tìm kiếm ngay lập tức? Trong khi đó, nhiều trang khác lại chìm vào quên lãng dù nội dung rất tốt? Câu trả lời nằm ở một quy trình nền tảng nhưng vô cùng quyền lực. Đó chính là thu thập dữ liệu. Hiểu rõ crawl data là gì và cách nó vận hành chính là chìa khóa thành công. Bạn sẽ không còn phải cầu may trong SEO nữa. Thay vào đó, bạn sẽ chủ động dẫn dắt bot khám phá website của mình.

Tại Backlink Cafe, chúng tôi coi đây là bước đi chiến lược đầu tiên cho mọi dự án.

Crawl data là gì?

Trong thế giới kỹ thuật số năm 2026, dữ liệu chính là nguồn tài nguyên quý giá nhất. Việc thu thập thông tin chính là bước khởi đầu để nội dung tiếp cận người dùng. Nếu website của bạn là một thư viện đồ sộ, thì các bot tìm kiếm là người thủ thư. Và dữ liệu crawl chính là bản báo cáo chi tiết về những gì họ đã thấy

Crawler, bot và spider: Những người đưa tin thầm lặng trên internet

Hiểu một cách đơn giản, crawl data là gì? Đó là toàn bộ thông tin mà các chương trình tự động thu thập được khi ghé thăm website. Các chương trình này thường được gọi là bot, spider hoặc crawler. Những cái tên nổi tiếng nhất gồm Googlebot, Bingbot hay các bot của những công cụ SEO lớn. Chúng làm việc miệt mài ngày đêm để quét qua hàng tỷ trang web. Mỗi lần ghé thăm, chúng đọc mã nguồn và ghi lại mọi thay đổi trên trang của bạn.

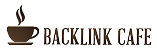

Sự khác biệt cốt lõi giữa thu thập dữ liệu và lập chỉ mục

Nhiều người thường nhầm lẫn giữa hai khái niệm này. Thu thập dữ liệu là bước đi trước, lập chỉ mục là bước theo sau. Quá trình crawl data là gì sẽ thu thập nguyên liệu thô cho Google. Sau đó, hệ thống sẽ phân tích nội dung đó để đưa vào kho lưu trữ (index). Nếu bot không thể crawl, trang web của bạn coi như không tồn tại trên bản đồ tìm kiếm. Việc tối ưu hóa quy trình này giúp website của bạn luôn được cập nhật nhanh nhất.

Tại sao hiểu rõ crawl data là gì lại quyết định sự sống còn của website?

Nếu bạn coi SEO là một cuộc chơi dài hạn, tối ưu hóa crawl là việc đảm bảo luật chơi đúng. Việc nắm vững crawl data là gì giúp bạn kiểm soát hoàn toàn hiệu suất hiển thị. Dưới đây là những lý do cụ thể mà doanh nghiệp cần quan tâm.

Khả năng hiển thị cơ bản: Nếu không thấy, Google sẽ không xếp hạng

Đây là quy luật đơn giản nhất của giới công nghệ. Nếu bot không thể tiếp cận trang của bạn, nó sẽ không bao giờ được lập chỉ mục. Không có index nghĩa là không có lượt truy cập tự nhiên. Hiểu rõ crawl data là gì giúp bạn phát hiện các lỗi ngăn bot truy cập kịp thời. Bạn có thể sửa lỗi 4xx, 5xx hay cấu hình sai tệp robots.txt nhanh chóng. Điều này đảm bảo cánh cửa website luôn mở rộng chào đón các con bot.

Tối ưu ngân sách thu thập thông tin cho các website quy mô lớn

Khái niệm ngân sách thu thập (Crawl Budget) cực kỳ quan trọng với website lớn. Đây là số lượng trang mà Google sẵn sàng quét trên site của bạn trong một thời gian. Khi phân tích crawl data là gì, bạn sẽ biết cách điều hướng bot hiệu quả hơn. Bạn có thể ưu tiên bot tập trung vào các trang mang lại doanh thu cao. Đồng thời, bạn sẽ giảm thiểu tài nguyên vào các trang trùng lặp hoặc kém chất lượng.

Chẩn đoán sức khỏe kỹ thuật của website thông qua dữ liệu crawl

Dữ liệu thu thập là tấm gương phản chiếu sức khỏe kỹ thuật của bạn. Nó cho bạn biết tốc độ tải trang thực tế mà bot cảm nhận được. Nó chỉ ra cấu trúc liên kết nội bộ có thực sự mạch lạc hay không. Qua đó, bạn có thể xử lý các vấn đề về nội dung mỏng hay liên kết hỏng. Tại Backlink Cafe, chúng tôi sử dụng dữ liệu này để đưa ra những điều chỉnh chính xác nhất.

Quy trình vận hành chi tiết của quá trình crawl data là gì?

Để hình dung rõ hơn, hãy cùng theo chân Googlebot trong một nhiệm vụ điển hình. Quá trình tạo ra crawl data là gì sẽ diễn ra qua bốn giai đoạn chính.

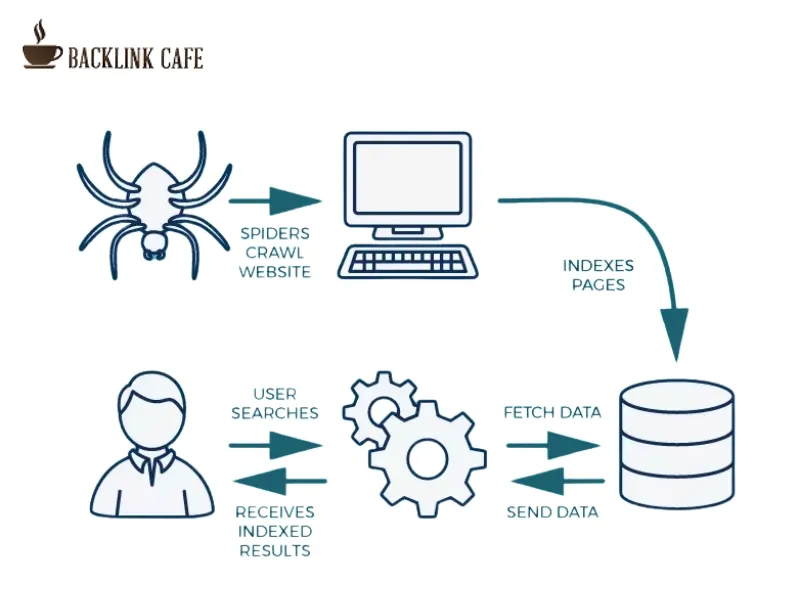

Giai đoạn 1: Khám phá URL thông qua sitemap và hệ thống backlink

Googlebot bắt đầu từ một danh sách khổng lồ các địa chỉ URL đã biết. Danh sách này đến từ các lần quét trước đó hoặc từ sơ đồ trang web (sitemap). Đặc biệt, các liên kết từ website khác trỏ về (backlink) là kênh khám phá cực mạnh. Nếu website bạn có liên kết từ trang uy tín, bot sẽ ghé thăm bạn thường xuyên hơn. Đây chính là điểm khởi đầu cho chuỗi hoạt động crawl data là gì.

Giai đoạn 2: Gửi yêu cầu và tải mã nguồn HTML về máy chủ Google

Bot sẽ gửi yêu cầu đến máy chủ của bạn để tải về mã HTML. Giai đoạn này phụ thuộc rất nhiều vào tốc độ của dịch vụ Hosting. Nếu máy chủ phản hồi chậm, dữ liệu quét sẽ ghi nhận website bạn là “khó tiếp cận”. Điều này ảnh hưởng trực tiếp đến đánh giá của thuật toán về hiệu suất trang web. Tốc độ chính là yếu tố vàng trong quy trình crawl data là gì hiện đại.

Giai đoạn 3: Phân tích cú pháp và trích xuất thông tin quan trọng

Sau khi tải trang, bot tiến hành đọc các thành phần nội dung. Nó trích xuất văn bản, tiêu đề, mô tả meta và các thẻ hình ảnh. Đồng thời, nó ghi nhận các tệp CSS và JavaScript để hiểu cách trang hiển thị. Tập hợp thông tin này sau mỗi lần quét chính là sản phẩm của quá trình crawl data là gì. Đây là dữ liệu thô để Google bắt đầu giai đoạn xếp hạng sau này.

Giai đoạn 4: Đưa URL mới phát hiện vào hàng đợi thu thập

Trong lúc đọc nội dung, bot sẽ tìm thấy các liên kết mới trên trang. Những URL này sẽ được đưa vào hàng đợi để quét trong tương lai. Đây là lý do vì sao cấu trúc liên kết nội bộ đóng vai trò then chốt. Nếu bạn kết nối các trang tốt, bot sẽ khám phá toàn bộ website của bạn dễ dàng. Chu kỳ này lặp lại liên tục, tạo nên sự vận hành của crawl data là gì.

Các yếu tố ảnh hưởng trực tiếp đến hiệu quả crawl data là gì?

Hiểu bản chất là một chuyện, tối ưu nó lại là câu chuyện khác. Nhiều yếu tố kỹ thuật có thể thúc đẩy hoặc ngăn cản quá trình này. Bạn cần kiểm soát chặt chẽ các yếu tố ảnh hưởng đến crawl data là gì.

Tốc độ phản hồi của máy chủ và chất lượng dịch vụ Hosting

Máy chủ nhanh giúp bot quét được nhiều trang hơn trong cùng một thời gian. Ngược lại, hosting kém chất lượng sẽ làm lãng phí ngân sách thu thập của bạn. Tại Backlink Cafe, chúng tôi luôn khuyến nghị khách hàng sử dụng hạ tầng mạnh mẽ. Một giây chậm trễ của máy chủ có thể khiến hàng trăm trang web không được quét kịp thời.

Xem thêm: SEO Hosting xây PBN với IP riêng biệt bí quyết bứt phá thứ hạng Google

Cấu trúc liên kết nội bộ và vai trò của sơ đồ trang web XML

Sơ đồ trang web giống như bản đồ dẫn đường cho các con bot. Nếu không có bản đồ, bot có thể bị lạc hoặc bỏ sót các khu vực quan trọng. Bên cạnh đó, hệ thống liên kết nội bộ mạch lạc giúp truyền sức mạnh giữa các trang. Điều này làm tăng tần suất xuất hiện của bot tại các trang đích quan trọng nhất. Tối ưu cấu trúc chính là tối ưu hóa hiệu quả crawl data là gì.

Tác động của tệp robots.txt và các thẻ meta chỉ dẫn cho bot

Tệp robots.txt là nơi bạn đưa ra chỉ dẫn cho các con bot. Bạn có thể yêu cầu bot không quét các khu vực nhạy cảm như trang quản trị. Tuy nhiên, một sai sót nhỏ trong tệp này có thể chặn đứng toàn bộ website. Bạn cần kiểm tra kỹ lưỡng các thẻ meta noindex để không vô tình đuổi bot đi. Việc quản lý các tệp chỉ dẫn là phần không thể thiếu khi nghiên cứu crawl data là gì.

Giải pháp tối ưu hóa crawl data là gì từ chuyên gia Backlink Cafe

Tại Backlink Cafe, chúng tôi không chỉ cung cấp dịch vụ, chúng tôi cung cấp giải pháp. Chúng tôi giúp bạn dẫn dắt bot đi đúng lộ trình để đạt thứ hạng cao nhất.

Xây dựng cấu trúc Silo giúp bot hiểu sâu nội dung website

Chúng tôi tổ chức nội dung website theo các chủ đề chuyên sâu (silo). Cách làm này giúp bot dễ dàng hiểu được chủ đề chính của từng khu vực. Khi bot di chuyển dễ dàng, dữ liệu quét sẽ được ghi nhận một cách tích cực hơn. Cấu trúc silo mạnh mẽ chính là bệ phóng cho quá trình crawl data là gì hiệu quả. Chúng tôi cam kết giúp website bạn trở nên khoa học và thân thiện với mọi công cụ tìm kiếm.

Xây dựng hệ thống backlink chất lượng cao để dẫn lối cho bot

Backlink không chỉ để tăng hạng, nó còn là “đường cao tốc” cho bot. Khi có liên kết từ các trang báo lớn trỏ về, bot sẽ tìm thấy bạn nhanh hơn. Tần suất bot ghé thăm website của bạn sẽ tăng lên đáng kể. Đây là cách gián tiếp nhưng cực mạnh để tối ưu hóa crawl data là gì. Với nguồn tài nguyên liên kết báo chí đa dạng, chúng tôi tự tin giúp website bạn được Google ưu tiên đặc biệt.

Các công cụ phân tích crawl data là gì mạnh mẽ nhất năm 2026

Để quản trị dữ liệu hiệu quả, bạn cần những công cụ chuyên dụng. Google Search Console là trợ thủ đắc lực nhất và hoàn toàn miễn phí. Nó cho bạn biết chính xác có bao nhiêu trang đã được lập chỉ mục thành công. Ngoài ra, các công cụ như Screaming Frog hay Sitebulb giúp bạn mô phỏng hoạt động của bot. Qua đó, bạn có thể tìm thấy các liên kết hỏng hay nội dung trùng lặp nhanh chóng. Việc sử dụng công cụ giúp quá trình kiểm soát crawl data là gì trở nên trực quan hơn.

Bước sang năm 2026, với sự bùng nổ của AI, bot tìm kiếm sẽ ngày càng thông minh. Chúng không chỉ đọc mã nguồn mà còn hiểu được ý nghĩa sâu xa của nội dung. Vì vậy, tối ưu hóa kỹ thuật phải đi đôi với giá trị nội dung thực thụ. Sự kết hợp giữa nền tảng kỹ thuật và chiến lược backlink đột phá sẽ quyết định thành công.

Tầm nhìn dài hạn về crawl data là gì trong chiến dịch SEO

Tóm lại, hiểu rõ crawl data là gì không còn là công việc của riêng kỹ thuật viên. Nó là bức tranh toàn cảnh về sự hiện diện của doanh nghiệp trên internet. Bằng cách chủ động tối ưu và dẫn dắt bot, bạn đang đặt những viên gạch vững chắc đầu tiên. Hãy để website của bạn được Google khám phá một cách đầy đủ và trân trọng nhất. Đừng để những rào cản kỹ thuật ngăn cản khách hàng đến với bạn. Hãy bắt đầu hành trình tối ưu hóa ngay hôm nay cùng chúng tôi. Backlink Cafe luôn sẵn sàng đồng hành để đưa website của bạn lên tầm cao mới bền vững.