Tạo file robot txt là một nội dung quan trọng trong SEO. Vậy tao file robot txt ra sao và để làm gì? Hãy cùng chúng tôi tìm hiểu ngay sau đây!

Ở bài viết trước, khi cùng tìm hiểu về search engine là gì và cơ chế hoạt động của SE, mình đã giải thích cơ bản và ngắn gọn cách mà các SE hoạt động. Trong đó có nhắc tới việc các SE sẽ như một chú nhện bò khắp các website trên mắt lưới để thu thập dữ liệu. Đúng vậy, cụ thể hơn trong bài viết này các bạn sẽ hiểu rằng, các SE đi trên mắt lưới bằng cách cử các con bots – con bọ máy tính (hay mình thích gọi là các em nhện hơn) đi lượn lờ khắp nơi trên mạng Internet khổng lồ. Và để hỗ trợ việc thu thập dữ liệu một cách nhanh chóng hơn, được sắp xếp vào kho dữ liệu sớm hơn bình thường sẽ cần đến file robot.txt.

Tạo file robot txt để làm gì?

Các file robot txt giống như một cái la bàn nho nhỏ cho website của bạn để định hướng cho các em nhện đi ra sao. Kiểu như một hướng dẫn viên du lịch vậy, bảo em nhện đi qua đây, đi qua đấy nè, vì ở đây mới chứa các dữ liệu quan trọng và cần thiết để website lên top SE; đừng đi qua chỗ kia vì chỗ đấy không quan trọng mấy đâu…

Tạp file robot txt có tác dụng gì? Có cần thiết không?

À thì nếu website của bạn không quá lớn thì Google cũng có nói rằng việc tạo file robot txt là không nhất thiết. Nghĩa là kiểu gì thì các em nhện cũng bò hết cái website của bạn thôi. Tuy nhiên là nó sẽ không được trọng tâm trọng điểm. Không những vậy khi lắm nhện bò lổm ngổm trong website thì website của bạn sẽ trở nên chậm chạp, việc loading sẽ gây khó chịu cho người dùng.

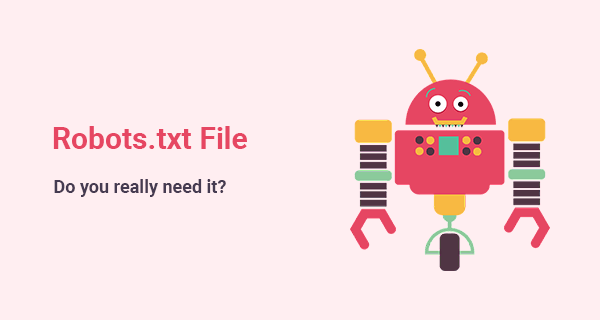

Tạo file robot txt gồm có những thành phần nào?

Trên hình là một định dạng cơ bản nhất cho việc tao file robot txt. Ví dụ tiêu biểu cho cấu trúc này như sau:

Đây là cấu trúc cơ sở của một robots.txt hoạt động cho trang web www.example.com:

User-agent: *

Disallow: /wp-admin/

Allow: /

Sitemap: https://www.example.com/sitemap_index.xml

Ví dụ trên được hiểu như sau: Cho phép toàn bộ các công cụ tìm kiếm theo link www.example.com/sitemap_index.xml để tìm đến file robots.txt phân tích và index toàn bộ các dữ liệu trong các trang trên website của bạn ngoại trừ trang www.example.com/wp-admin/

Tuy nhiên, các phần “crawl-delays” và “sitemap” không nhất thiết phải có trong cú pháp trên. Một file robot txt có thể chứa nhiều dòng user – agent và nhiều lệnh như Disallow, allows, crawl – delays…Trên robot txt của website bạn có thể chỉ định các em nhện đi theo các lệnh khác nhau, mỗi lệnh nằm trên một dòng. Còn nếu viết liên tục không cách dòng thì các em nhện sẽ thực hiện tất cả các lệnh bạn chỉ định cho chúng. Tất nhiên thì đôi khi các em nhện sẽ thực hiện lệnh được viết cụ thể và rõ ràng hơn trong tất cả các lệnh trong file robot txt. Dưới đây là cách hiểu một số cú pháp trong robot txt:

- Cú pháp lệnh để chặn tất cả các website crawler không được thu thập bất kì dữ liệu nào trên website bao gồm cả trang chủ:

User-agent: *

Disallow: /

- Cú pháp để cho phép tất cả các trình thu thập thông tin truy cập vào tất cả nội dung trên website bao gồm cả trang chủ:

User-agent: *

Disallow:

- Cú pháp để chặn trình thu thập thông tin của Google (User-agent: Googlebot) không thu thập bất kì trang nào có chứa chuỗi URL www.example.com/example-subfolder/:

User-agent: Googlebot

Disallow: /example-subfolder/

- Cú pháp để chặn trình thu thập thông tin của Bing (User-agent: Bing) tránh thu thập thông tin trên trang cụ thể tại www.example.com/example-subfolder/blocked-page:

User-agent: Bingbot

Disallow: /example-subfolder/blocked-page.html

Như vậy về cơ bản chúng ta đã cùng tìm hiểu về khái niệm file robot txt, sử dụng file robot txt để làm gì và cấu trúc cơ bản của file này ra sao. Ở các bài viết sau chúng ta sẽ cùng tiếp tục tìm hiểu kỹ hơn các nội dung liên quan đến SEO nhé!